X. Intelligence

Introduction

Ce chapitre distingue les intelligences individuelle, collective et artificielle, car (i) l'intelligence collective est (plus que) la somme d'intelligences individuelles, et (ii) l'intelligence artificielle, telle qu'elle a été développée jusqu'à aujourd'hui, est une technologie d'intelligence collective dans la mesure où elle repose sur l'exploitation de données produites par la collectivité humaine.

Il est également utile de distinguer les notions de :

- science, qui vise à comprendre les phénomènes naturels ;

- techniques, qui visent à exploiter des connaissances acquises par la science, afin d'améliorer notre bien-être (notion d'utilité et d'efficacité), et cela de deux façons possibles :

les techniques naturelles le font sans transformer l'environnement, et par conséquent minimisent l'énergie "consommée" (en fait transformée), ce qui minimise la production anthropique de chaleur (cf. les premier et second principes de la thermodynamique : allocation-universelle.net/thermodynamique#energie-principes);

les techniques artificielles, encore appelées technologies, le font au moyen de machines (avions, ordinateurs, bases de données, ...), fabriquées par le conditionnement (travail) de matières premières (capital), ce qui requiert de transformer beaucoup d'énergie, et donc de produire beaucoup de chaleur.

La relation de causalité n'est pas toujours dans le sens théorie (fondamentale) ⇒ technologies. Ainsi c'est la création, par essais-erreurs, de la machine à vapeur (18° siècle) qui a induit le développement d'un corpus théorique dénommé "thermodynamique" (19° siècle).

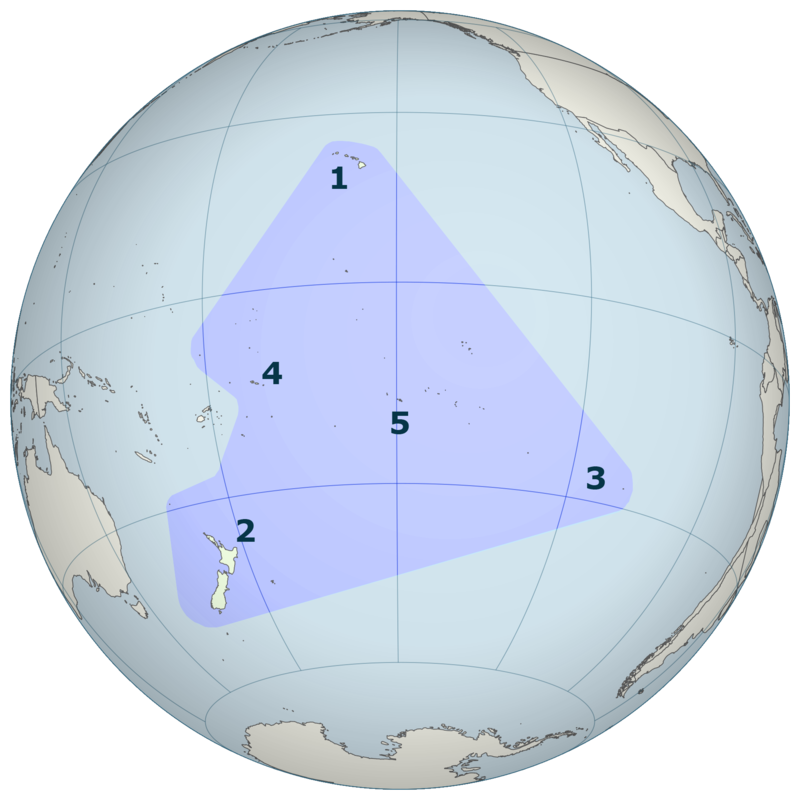

Les îles situées à l'intérieur du « triangle polynésien » forment la Polynésie (1 : Hawaï ; 2 : Nouvelle-Zélande ; 3 : Île de Pâques ; 4 : Samoa ; 5 : Tahiti) [source].

Par exemple, la géolocalisation est une technique qui peut être appliquée :

naturellement, à l'instar des populations indigènes de Polynésie pour se déplacer entre îles, en observant les positions des étoiles, la direction du vent et des courants, ...) ;

- artificiellement : cf. GPS, qui fonctionne au moyen de satellites.

La dynamique du progrès est très différente entre :

d'une part, les techniques naturelles utilisées par l'ensemble des organismes vivants, dont le progrès résulte du phénomène lent qu'est l'évolution, qui produit des techniques extrêmement efficaces en terme de consommation énergétique ;

d'autre part, les techniques artificielles des humains, qui progressent beaucoup plus vite, mais au prix d'une énorme consommation d'énergie, et donc de production de chaleur.

L'intelligence est ce qui permet la science et les techniques, celles-ci étant l'expression de celle-là.

Il y une relation de boucle rétroactive entre les trois couples constitutifs du triangle individuel-collectif-artificiel :

Le triangle des intelligences - © François Jortay

Chaque boucle crée des effets d'amplification et de transformation mutuels. La dynamique globale fait émerger un système d'intelligence augmentée où les trois dimensions se renforcent mutuellement.

Il importe cependant que l'IA soit également accessible aux individus, ce qui requiert un contrôle démocratique de moyens de production de l'IA, via des coopératives publiques.

Intelligence individuelle

2. Composantes

3. Conscience

4. Capacités analytiques

5. Apprentissage

6. Fondements biologiques

7. Humain vs animal

8. Humain vs machine

9. Déclin

Humaine

Partant de l'hypothèse que l'intelligence existe en tant que caractéristique propre aux organismes vivants, nous entendons par "intelligence individuelle", l'intelligence d'un organisme biologique. Nous nous intéressons ici en particulier à l'intelligence individuelle des humains.

Composantes

L’épistémologue Jean Piaget, fondateur du structuralisme génétique et spécialiste de l’apprentissage, disait que « l’intelligence, ça n’est pas ce que l’on sait, mais ce que l’on fait quand on ne sait pas ».

1. Composantes quantitatives2. Composantes qualitatives

Composantes quantitatives

On peut distinguer deux types de composantes quantitatives de l'intelligence, consistant en la capacité de traitements des informations, et pouvant être mesurées objectivement par :

- la capacité de stockage (mémorisation) des informations ;

- la vitesse de "calcul" des informations.

Ces capacités de traitement de données ne sont pas typiquement humaines puisqu'elles sont également (i) reproductibles par des machines (qui peuvent dépasser les capacités humaines en la matière), et (ii) observées chez les animaux (avec des performances généralement inférieures à celles des humains).

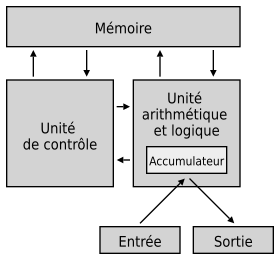

Dans tout système "intelligent" (biologique ou électronique), ces deux capacités sont précédées par la perception & collecte de données brutes, puis se concluent par la phase de représentation des données traitées, et de leur interprétation.

- perception (collecte de données), au moyen d'un système sensoriel ;

- mémorisation ;

- traitement ;

- représentation ⇒ interprétation.

Il y donc, entre l'étape initiale de perception des données brutes et l'étape finale d'interprétation de leur représentation, une série de phases intermédiaires, qui peuvent biaiser les données, quantitativement (ex. : pertes de mémoire) et qualitativement (ex. erreurs de calcul).

Questionnement : qu'est-ce qui distingue la représentation de l'interprétation ? Pour répondre à cette question il faudra commencer par déterminer comment l'une et l'autre fonctionnent.

Les différences individuelles apparaissent notamment au niveau de l'accumulation des informations avec le temps. Ainsi pour Landemore, le concept de sagesse est plus riche que celui d’intelligence, puisqu’il recouvre les notions d’expérience, de connaissance éprouvée par le temps et, de façon plus générale, celle d’intelligence diachronique [source]. Cependant avec la vieillesse, la vitesse de traitement des données tend à baisser.

L'analyse quantitative doit être complétée par un volet qualitatif, si l'on veut cerner l'intelligence dans toute la subtilité et diversité que l'on constate chez les humains ...

Composantes qualitatives

Dans la section précédente nous avons souligné le fait que les composantes quantitatives de l'intelligence se retrouve aussi bien chez les humains que dans l'IA. Il y a cependant une différence de nature dans leur fonctionnement : alors que les capacités quantitatives des ordinateurs sont mesurées en termes binaires, celle des humains sont plutôt d'ordre analogique.

L'unité logique des logiciels d'un ordinateur est le byte (noté B ou o), soit huit bits (noté b). Un bit est une unité qui peut prendre deux valeurs : 1 (présence de courant électrique) ou 0 (absence de courant électrique). Ainsi dans un ordinateur, les capacités de stockage sont mesurées en bytes, et la vitesse de calcul en bytes/seconde.

Il y a donc une différence de nature entre systèmes biologique et électronique. Alors que dans ce dernier les données sont échangées uniquement via des signaux électriques, chez les organismes biologiques, les signaux électriques peuvent être combinés à des signaux chimiques (cf. clipedia-txt.net/biologie#systeme-nerveux-cerveau), ce qui augmente considérablement les potentialités des systèmes biologiques, en termes de fonctionnalités et de performance, ... par unité d'énergie consommée.

Dans la section consacrée consacrée à l'IA, nous verrons que l'efficacité énergétique des humains est très supérieure à celle des ordinateurs, ce qui conduit les ingénieurs à concevoir des ordinateurs biologiques, composés de cellules biologiques ...

Parmi les composantes qualitatives de l'intelligence, on peut distinguer :

l'intelligence critique, relevant de la capacité à évaluer la qualité d'une information (est-elle vraie ou fausse ? ; est-elle baisée ? ; la différence entre la réalité et sa représentation est-elle fortuite ou intentionnelle ? ; ... ;

- l'intelligence émotionnelle, relevant du jugement de valeur ;

- l'intelligence relationnelle, relevant de l'empathie (et pouvant être guidée par la bienveillance comme par la malveillance).

- l'intelligence créative, relevant de l'imagination.

Les machines sont capables d'imiter ces capacités, ce qui est déjà pas mal, et d'autant plus lorsqu'il y a amplification de la capacité. Par "imiter", nous entendons ici l'absence de conscience, d'intentionnalité ou encore d'éthique. Nous postulerons ainsi que, contrairement à la réaction, la proaction est le résultat d'une volonté, laquelle requiert une conscience : proaction ⇐ volonté ⇐ conscience.

Conscience

Définition

« La conscience est un concept complexe et multifacette qui fait référence à la capacité d'un être vivant, en particulier l'être humain, à percevoir, à ressentir, à avoir une compréhension de soi-même et du monde qui l'entoure. C'est l'état mental de veille et d'auto-observation qui nous permet de penser, de ressentir, de réfléchir, de prendre des décisions et d'interagir avec notre environnement. La conscience englobe la perception sensorielle, la réflexion, l'émotion, la mémoire, la pensée, et d'autres processus cognitifs » [chatGPT, nov. 2023].

Ces propositions composites suscitent la question de la relation entre intelligence (I) et conscience (C) :

- I ⇒ C ?

- I ⇐ C ?

- I ⇔ C ?

- I ≡ C ?

- ... ?

Le philosophie et physicien Dominique Lambert, en énonçant des capacités supposées distinguer l'humain des autres animaux (et des robots), suggère une forte intrication entre conscience et intelligence. Ainsi selon lui, l'humain serait particulièrement efficace dans sa capacité à :

- dépasser sans cesse les limites du langage pour l'interpréter et donner du sens ;

- sortir de ses propres représentations décrivant sa nature ;

- assumer des risques en dehors de ce qui est rigoureusement calculable ;

Lambert cite cet élément dans le cadre d'une argumentation contre l'abandon de nos décisions à des systèmes d'intelligence artificielle (notamment dans la justice) qui, par nature, ne seraient pas capables de reproduire cette capacité.

- limiter sa toute-puissance et sa toute-maîtrise pour faire place à l'autre [source].

Dans son roman "Pantagruel" écrit en 1532, François Rabelais fait dire à Gargantua écrivant à son fils Pantagruel : « science sans conscience n’est que ruine de l’âme », distinguant ainsi le savoir de l'utilisation qu'on en fait.

Sur base des définition énoncées dans la section #composantes-qualitatives, on pourrait proposer que : « l'intelligence sans émotion ni empathie et bienveillance, n'est que ruine de l'âme », et ainsi souligner le rôle et l'importance de la composante qualitative de l'intelligence.

L'avertissement que nous adresse Rabelais suggère implicitement la notion de responsabilité, ce qui conduit à d'autre notions, telles que le libre arbitre et la volonté.

Déterminisme

inconscient ?

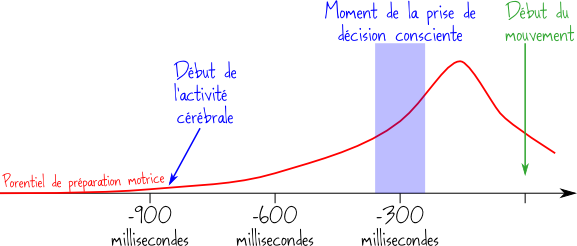

Une expérience réalisée en 1983 par Benjamin Libet montre que l’activation cérébrale (supposée inconsciente) précède la décision consciente. Dans une autre expérience réalisée en 2008 par Chun Siong Soon l'activation cérébrale est observée jusqu'à 10 secondes avant la décision consciente, et en outre l'observation des zones cérébrales activées permet dans 60% des cas de prédire correctement le type de décision que l'individu observé prendra. En 2011, utilisant une autre technologie Itzhak Fried obtient un taux de prédiction correcte de 80%, 700 millisecondes avant la décision consciente [source]. Doit-on en déduire que le libre-arbitre ne serait qu'une illusion rétrospective sur nos actes ? Ne serions-nous que des feuilles balancées par le vent du déterminisme ?

Quelques questionnement et faits viennent tempérer une éventuelle réponse affirmative à ces questions :

L'activation neuronale précédant la décision n'est-elle pas déterminée par la participation volontaire de l'individu à l'expérience ?

Si nous subissons, en provenance de notre environnement, des influences dont nous n'avons pas nécessairement conscience, il demeure que c'est justement le laps de temps entre intention/volonté et décision qui permet éventuellement à l'individu de ne pas passer à l'acte. Ainsi la conscience est liée à la réflexion, laquelle procède selon un mécanisme de boucle de rétroaction et d'inférence bayésienne [source].

Le phénomène étudié dans les expériences mentionnées ci-dessus ne doit pas être confondu avec le réflexe, qui est une réaction musculaire stéréotypée et très rapide à un stimulus, sans intervention du cerveau et de la volonté consciente

Des expériences ont montré que les individus qui croient dans le déterminisme de l'être humain, ont plus tendance à se comporter de façon malhonnête que des individus croyant dans leur libre arbitre. Ainsi, fondée ou non, la croyance dans le libre-arbitre présente l'avantage d'être socialement éthique.

Biais

cognitifs

Les individus n'étant généralement pas conscient de leurs biais cognitifs, l'interaction avec des systèmes intelligents peut aider à faire émerger ces biais dans la conscience. C'est incontestablement une prouesse de l'intelligence humaine que de concevoir de tels outils.

Perception et conscience (2020, 2m22s)

Axel Cleeremans est professeur de psychologie cognitive à l'Université Libre de Bruxelles.

Conscience

artificielle ?

Pourrait-on fabriquer des machines conscientes ? Oui affirme la théorie computationnaliste, à l'instar du psychologue Philip Johnson-Laird qui énonce les conditions suffisantes à vérifier pour créer des ordinateurs conscients [source : « A computational analysis of consciousness » 1988]. Au contraire, le mathématicien Roger Penrose soutient que les ordinateurs, considérés comme des machines de Turing ou des systèmes formels, sont fondamentalement dans l'incapacité de modéliser l'intelligence et la conscience. Les ordinateurs étant des systèmes déterministes, ils sont soumis aux limitations des systèmes formels, par exemple l'insolvabilité du problème de l'arrêt ou le théorème d'incomplétude de Gödel. Selon Penrose, l'esprit d'un authentique mathématicien est capable de surmonter ces limitations, car il a la capacité de s'extraire au besoin du système formel dans lequel il raisonne, quel que soit celui-ci [source].

Capacité analytique

Notre capacité de raisonnement est fondée sur une capacité à synthétiser une problématique c-à-d à identifier les facteurs explicatifs d'un phénomène, puis à décrire leur relations, sous forme d'un modèle.

Une méthode de modélisation est la théorie des graphes, dont des applications peuvent prendre la forme d'algorithmes.

La capacité d'abstraction, dont le langage mathématique est une expression, constitue une déterminant majeur de la capacité analytique des humains, laquelle est constamment augmentée par l'extension du langage mathématique aux processus informatiques, permettant ainsi le traitement de données en quantités et vitesses phénoménales.

Python est un langage très populaire pour coder des algorithmes.

Ces capacités d'abstraction de l'intelligence humaine ne se retrouvent pas (ou à des ordres de grandeur très inférieurs) chez les animaux. Par contre, les ordinateurs surpassent généralement les capacités d'abstraction des humains. Ainsi par exemple, notre capacité à interpréter la notion mathématique d'espace s'effondre à partir de la dimension 3 (qui est celle de notre environnement physique), alors que la limite des ordinateurs se situe à un ordre de grandeur très supérieur (et rapidement croissant, grâce au progrès technologique).

L'analogie est une autre capacité fondamentale de l'intelligence.

Un exemple d'analogie est « abc est à abd ce que pqr est à ... ? », dont une notation mathématique est abc:abd :: pqr:?

Méthode

scientifique

Une problématique fondamentale de la dynamique cognitive est que le scientifique ne peut totalement s'extraire des phénomènes qu'il étudie, ce qui peut biaiser ses analyses, notamment en influençant les données brutes, ou encore via l'interprétation qu'il fait des phénomènes observés. La méthode scientifique vise à minimiser ces biais, et plus généralement à rationaliser l'étude des phénomènes naturels. Elle s'inscrit dans un cycle rétroactif composé de quatre phases : observation --> théorisation --> prédiction --> expérimentation --> observation.

La liste qui suit, non exhaustive, énonce des notions qui composent la méthode scientifique :

- hypothèse & thèse ;

- observation ;

- mesure ;

- typologie & classification ;

- théorie ;

- modélisation ;

- démonstration ;

- expérimentation ;

- protocole ;

- calcul ;

- probabilité ;

- logique ;

- référentiel & relativité ;

- induction & déduction ;

- réfutation & réfutabilité ;

- heuristique ;

- évaluation par les pairs ;

- transdisciplinarité & inter-disciplinarité ;

- ...

Il n'y a évidemment aucune raison pour que la rationalité ne soit appliquée que dans le domaine scientifique. Il est dans l'intérêt de tout individu d'appliquer les principes ci-dessus, notamment dans la gestion de projets, ou encore dans ses relations avec autrui. C'est pourquoi la méthode scientifique devrait faire partie de la formation de base universelle.

Déduction vs induction

La déduction consiste à tirer des conclusions logiques à partir de prémisses données, tandis que l'induction consiste à généraliser à partir d'observations spécifiques pour tirer des conclusions plus larges.

Il y a une différence qualitative : le résultat d’une inférence suivant un raisonnement inductif, même basé sur des milliards d’exemples, peut toujours être démenti par un contre-exemple ou par plusieurs contre-exemples, tandis qu'une conclusion obtenue par déduction, si les prémisses sont vraies et le raisonnement valide, est nécessairement vraie. Ainsi on peut dire que la déduction est une démarche théorique tandis que l'induction est une démarche expérimentale. Les deux approches sont complémentaires : l'induction permet de formuler des hypothèses à partir d'observations, tandis que la déduction permet ensuite de tester ces hypothèses en dérivant leurs conséquences logiques et en les confrontant à la réalité.

Il existe également un troisième type de raisonnement, l'abduction, qui consiste à formuler la meilleure explication possible à partir d'observations (utilisé en sciences ou en diagnostics

En matière de déduction, les humains ont historiquement montré une grande habileté, en particulier dans des domaines tels que la logique formelle, les mathématiques et la résolution de problèmes. Les compétences en déduction des humains peuvent être très développées et peuvent rivaliser efficacement avec celles des systèmes d'IA, en particulier dans les domaines où la compréhension conceptuelle et la manipulation symbolique sont importantes.

En revanche, en matière d'induction, les systèmes d'IA ont souvent un avantage significatif en raison de leur capacité à traiter de grandes quantités de données et à identifier des modèles complexes. Les algorithmes d'apprentissage machine et d'apprentissage profond sont capables d'apprendre à partir de vastes ensembles de données pour faire des prédictions et prendre des décisions dans des domaines tels que la reconnaissance de motifs, la classification, la prédiction et bien d'autres.

Apprentissage et adaptation

Adaptabilité : capacité d’améliorer les performances grâce à l’apprentissage par l’expérience [source].

On pourrait réécrire cette définition comme suit :

expérience ⇒ apprentissage ⇒ amélioration des performances ≡ adaptation.

- expérience ≡ collecte de données

- apprentissage ≡ analyse et transformation des données en informations.

L'apprentissage, qui repose notamment sur la collecte et l'intégration d'informations, permet l'adaptation d'une entité (individu ou organisation) à son environnement (ou plus exactement aux changements dans la relation biunivoque avec l'environnement).

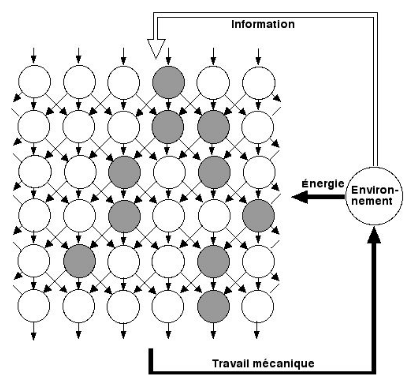

Selon le physicien François Roddier, « Pris isolément, tout animal cherche à maximiser ses chances de survie (de dissiper de l’énergie). Pour cela, il répond à des stimuli (informations venant de l’environnement) en déclenchant des actions appropriées (travail mécanique). Le comportement le plus intelligent est celui qui déclenche le plus rapidement les actions les mieux appropriées » [source].

L'intelligence apparaît ainsi comme une capacité à comprendre notre environnement et à y déterminer l’action à réaliser pour optimiser des "conditions de vie" – le "bien-être" pour les économistes – tout en minimisant la consommation d'énergie.

La notion de compréhension est ici fondamentale. Elle induit la relation conscience ⇒ volonté ⇒ proaction, qui ne se réduit pas à la simple la capacité d'adaptation, également observée chez les corps inertes (matière non vivante). Ainsi les solides se dilatent à la chaleur, les liquides prennent la forme de leur conteneur, etc. Il n'y a pas là d'intentionnalité, mais simple réaction plutôt que proaction.

À supposer évidemment que l'intentionnalité ne soit pas une illusion ...

En toile de fond de cette dynamique conduisant du savoir à l'action, il y a l'apprentissage.

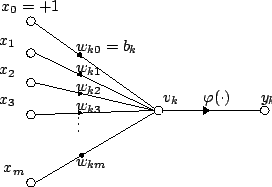

Bak et Stassinopoulos ont conçu un modèle de l'apprentissage, qui a été expérimenté en proposant un jeu à un singe : lorsque le voyant est vert il doit appuyer sur la pédale de droite, et quand il est rouge sur la pédale de gauche. À chaque réussite il reçoit une récompense (une cacahuète). Au début, la distribution des résultats est aléatoire, mais progressivement elle se rapproche de 100% d'essais réussis : l'apprentissage est alors réalisé. Le graphique suivant permet d'expliquer le mécanisme de cet apprentissage. Chaque essai correspond à un chemin entre la perception de la couleur et l'action qu'elle provoque (ou pas). Les connexions neuronales des chemins correspondant à des essais réussis serait progressivement renforcées (on dit que leur seuil est abaissé) tandis que les chemins correspondant à des essais ratés seraient progressivement inhibée (seuil renforcé) [source].

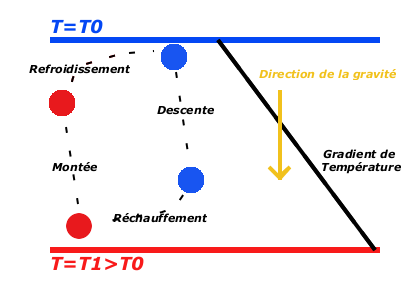

François Rodier propose une intéressante analyse thermodynamique de ce modèle. Elle repose sur le principe du cycle convectif.

Cycle convectif

Que se passe-t-il dans la casserole ?

Le modèle de cerveau de Bak et Stassinopoulos ci-dessus reçoit de l’information (Q2) de l’environnement sur lequel il agit (W=Q1-Q2) de façon à obtenir de l’énergie (Q1). Ainsi, à l'instar d'une machine thermique, ce modèle repose sur deux entrées et une sortie : l'une des entrées correspond aux calories apportées sous forme de nourriture (et correspond à l'apport de calories de la source chaude d'une machine thermique, c-à-d à une entrée d'entropie), tandis que l'autre entrée correspond à un apport d'information (et correspond à la source froide de la machine thermique, c-à-d à une sortie d'entropie).

Lorsqu'un neurone reçoit des signaux d'autres cellules il se charge électroniquement. Lorsque la charge dépasse un certain seuil le neurone est excité et transmet l'information à d'autres neurones. On observe alors des avalanches d'excitations. Les neurones excités (cercles gris) forment des domaines d'Ising d'autant plus étendus que les seuils sont faibles. (c-à-d que "les barrières sont basses"). La probabilité pour qu'un de ces domaines connecte les neurones sensoriels (ligne d'entrée dans le haut du graphique) aux neurones moteurs (ligne de sortie dans le bas du graphique) s'obtient en résolvant un problème mathématique dit de percolation [source p. 89-90].

François Roddier souligne que le modèle de Stassinopoulos et Bak relève de l'auto-organisation, et que celle-ci procède à l’aide d’oscillations de part et d'autre d’un point critique, seuil de percolation. Deux paramètres sont impliqués :

- l’intensité des connections entre les neurones (l'amplitude des avalanches d'excitations) : par analogie avec les cycles de Carnot, elle joue le rôle d’une pression : elle mesure un flux de charge comme la pression mesure un flux de particules qui frappent une paroi ;

- le seuil à partir duquel l’information est transmise d’un neurone à l’autre : par analogie avec les cycles de Carnot, les seuils jouent le rôle d’une température : des seuils bas facilitent leur franchissement (comme le ferait une température élevée) tandis que des seuils élevés empêchent leur franchissement (comme le ferait une température basse).

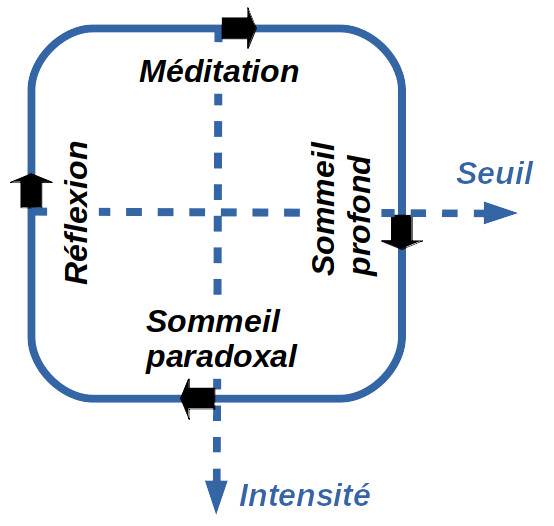

Le graphique ci-contre expose la dynamique entre seuils et intensités, au regard du cycle diurne du cerveau.

Ces deux paramètres oscillent au voisinage d'un point critique de sorte que l'apport énergétique est maximisé (cf. les cacahuètes qui récompensent les essais réussis du singe). Ces oscillations sont très utiles car, si trop de neurones moteurs sont excités, la valeur des seuils sera augmentée, et inversement (ainsi pour réfléchir, le cerveau doit être dans un état entre le sommeil et l'hyperactivité) Les fluctuations aléatoires permettent que le système ne reste pas piégé dans un optimum secondaire (cf. les oscillations de la température dans l'algorithme de recuit simulé, ou encore les équilibres ponctués en biologie) [source p. 89-90].

Roddier souligne que le modèle de Bak et Stassinopoulos permet d'expliquer :

- pourquoi le cerveau demeure capable de réapprendre même après ablation partielle : le système peut continuer de fonctionner même après suppression d'une partie des colonnes du graphique supra ;

- pourquoi très souvent au moment du réveil une solution apparaît au problème qui nous accaparait la veille : c'est à ce moment là que le cerveau traverse l'état critique [source p. 89-90].

Cycle diurne du cerveau

Le physicien François Roddier note l'analogie entre l'activité cyclique du cerveau telle que mesurée par électro-encéphalogramme (ondes thêta, bêta, alpha et delta), et le cycle convectif, ou encore le cycle des saisons [source].

| Cerveau | Convectif | Saison |

|---|---|---|

| Sommeil paradoxal (θ : 4-8Hz) | Réchauffement | Hiver (germination) |

| Réflexion (β : 15-30Hz) | Ascension (extension) | Printemps (croissance) |

| Méditation (α : 9-14Hz) | Refroidissement | Été (apogée) |

| Sommeil profond (δ : 1-3Hz) | Descente (compression) | Automne (régression) |

Conclusion importante : ces faits suggèrent que l'apprentissage n'est pas lié à la conscience. Nous verrons d'ailleurs que l'IA peut "apprendre".

Fondements biologiques

Selon l'état actuel des connaissances, le cerveau serait le siège de l'intelligence. Les neurones, connectés en un vaste réseau par des axones, communiquent entre eux au moyen d'une combinaison de messages chimiques (les neurotransmetteurs) et de signaux électriques (les potentiels d'action).

Voir aussi : https://clipedia-txt.net/biologie#systeme-nerveux-cerveau

La plasticité cérébrale, c-à-d la capacité du cerveau à s'adapter et à changer en réponse à l'expérience et à l'apprentissage repose notamment sur la capacité des synapses (les connexions entre les neurones) à être modifiées en fonction de l'activité neuronale. Ainsi l'apprentissage et la mémorisation sont associés à des changements dans la force des synapses : lorsqu'une synapse est régulièrement utilisée, elle peut renforcer sa connexion (potentiation synaptique), tandis que l'inactivité peut entraîner une affaiblissement de la connexion (dépression synaptique).

Les recherches sur les fondements biologiques de l'intelligence reposent notamment sur la distinction entre savoir routinier (inconscient) vs non routinier (conscient), ou encore entre savoir inné et acquis.

Concernant la mémoire, depuis le début des années 1970 et les études menées chez l’humain après des traumatismes cérébraux, on fait la distinction entre deux types de mémoire. La mémoire sémantique, qui est la mémoire factuelle de toutes les connaissances que nous avons sur le monde qui nous entoure, et la mémoire dite “épisodique”, qui est la mémoire des événements personnellement vécus et ancrés dans un contexte spatio-temporel. C’est cette mémoire épisodique qui est par exemple défaillante chez les personnes atteintes de la maladie d’Alzheimer [source].

Humain vs animal

Tout propriétaire d'un animal domestique peut constater que les animaux partagent avec l'homme la souffrance et le plaisir psychique. L'animal est donc un être sensible. Mais ce n'est pas tout. Des expériences suggèrent que les animaux sont capables d'inventer, de se projeter dans l'avenir, de comportements altruistes, d'éprouver un sens de la justice [source], ou encore de pratiquer l'humour (sous forme de jeux, tels que surprendre par derrière, voire simuler la colère) [source].

Se basant sur l'observation de différences de mode de vie entre entre groupes d'une même espèce, certains scientifiques parlent de "cultures animales". D'autres auraient même constaté des modifications comportementales dans le temps, ce qui les conduit à parler d'"accumulation culturelle", c-à-d d'évolutions sociétales dans le monde animal ... [source] .

Antropomorphisme

et wokisme ?

Dans quelle mesure ces travaux scientifiques sont-il biaisés par des biais d'expérimentation et d'interprétations anthropomorphiques, biais cognitifs très fréquents dans la pensée antispéciste et wokiste [source1, source2] ?

Métaphysique. Ainsi le sentiment religieux, ou encore la volonté de comprendre les lois de la nature pour le seul plaisir de la connaissance semblent spécifiques au genre humain, et le distinguer de l'animal (et de la machine).

Le suicide est-il spécifique au genre humain, ou la propension au suicide augmente-t-elle avec le degré d'intelligence de l'espèce considérée ? [source].

Langage et pensée. Quand on compare les langages humains aux systèmes de communication des primates non humains, on constate qu'il n'y a pratiquement pas d'aspect combinatoire chez ces derniers (cf. notion de grammaire). Ils ont bien un lexique, composé uniquement de mots, et peuvent composer des énoncés, mais ne dépassant quasiment jamais l'addition de deux mots. Il n'y a donc rien d'équivalent à la récursivité du langage humain, qui permet de créer une infinité potentielle de messages [source].

Commerce. La pratique des échanges commerciaux est préférable aux invasions et à l’esclavage, raison pour laquelle Montesquieu l'avait identifiée comme une antidote à la guerre. Or on observe des colonies de fourmis se faire la guerre, mais aussi échanger des biens (larves, nourritures, travailleurs). Cependant on a pas découvert chez des animaux l'usage d'une forme où l'autre de monnaie, comme substitut au troc. Ce fait montre que, même à supposer qu'il n'y ait pas de différence de nature entre hommes et animaux), il y a au moins une différence d'échelle dans les capacités qui constituent cette nature.

Civilisation. À une étudiante qui lui demandait ce qu’elle considérait comme le premier signe de civilisation l’anthropologue Margaret Mead ne mentionna pas les traditionnels silex ou l'usage du feu mais ... un fémur cassé qui avait guéri. Mead expliqua que dans le règne animal, un individu dont la patte est cassée sera éliminé par des prédateurs (éventuellement de sa propre espèce) en l'espace de quelques jours voire quelques heures, s'il ne peut les fuir. Un fémur cassé qui a guéri est la preuve que quelqu’un a pris soin du blessé jusqu’à son rétablissement. « Aider quelqu’un d’autre à traverser la difficulté c’est le début de la civilisation » conclut l’anthropologue [source].

Appétit intellectuel. Les animaux ne font pas de recherche fondamentale (dont la caractéristique, qui la distingue de la R&D, est de ne pas être motivée par d'autre objectifs déterminés que celui de découvrir). On pourrait être tenté d'y rapprocher le jeu, dont les animaux en bas âge sont coutumiers, et qui constitue certes une méthode de d'apprentissage efficace. Cependant, il n'y a là aucune volonté d'apprendre, mais seulement de jouer et d'imiter. La conséquence (l'effet) est identique, mais la méthode diffère.

Innovations et progrès. Ainsi, contrairement aux animaux, les humains continuent de progresser après avoir atteint l'âge adulte. En outre, les progrès individuels se propagent au niveau sociétal, grâce à son accumulation sous forme de mémoires matérielles (livres, ordinateurs, ...), au-delà de la durée de vie des individus (progrès civilisationnel).

Les humains progressent par un processus d'innovation double :

- imaginer d'autres causes d'un effet déterminé, pour améliorer la productivité de cet effet ;

- imaginer d'autres effets d'une cause déterminée, pour enrichir les utilisations de cette cause.

La crainte d'éventuelles calamités futures, et la conception anticipative de stratégies pour minimiser leurs conséquences, ne s'observe pas chez les animaux. Là encore, il ne faut pas confondre l’anticipation de schémas de causalité déjà observés (dont sont capables les animaux), et l’inférence de nouvelles possibilités à partir d’expériences passées (non observé chez les animaux) [source].

Conclusion

Concernant la distinction entre intelligence humaine VS animale VS artificielle, on pourrait distinguer deux conceptions :

dichotomique : il y aurait une intelligence spécifiquement humaine, qui n'est pas de même nature que celle des animaux ou des robots ;

la distinction de nature entre intelligences humaine et animale n'est pas très populaire dans la mouvance "wokiste", pour des raisons qui me paraissent moins scientifiques qu'idéologiques [exemple].

en continuum : l'intelligence serait une notion commune aux humains, animaux et machines, mais à des échelles (intelligence humaine supérieure à celle des animaux, et potentiellement inférieure à celles des robots ?).

Différentiels de performance entre humains. Selon la psychologue et chercheuse en science cognitive Fanny Nusbaum , la performance ne serait qu'un « état », que certains ont plus de facilité à atteindre que d’autres, mais qui peut concerner quasiment tout le monde, pour peu qu’on se mette dans les bonnes dispositions [source].

L’éthologue Cédric Sueur propose une troisième approche, considérant l’intelligence animale ou les intelligences animales dans leur singularité – chaque espèce réagit avec ses propres contraintes et dans son propre milieu (*) –, sans chercher à les comparer d’un point de vue qualitatif avec l’intelligence humaine, ni à établir une nouvelle hiérarchie au sein du règne animal.

(*) Par exemple, des oiseaux réagissent positivement au test du miroir, utilisé pour juger de l’aptitude à la conscience de soi, mais pas les chiens. Or, ce dispositif fait appel uniquement au sens de la vue, et des tests du même ordre adaptés au sens de l’odorat ont montré que les chiens y réagissent positivement…

« L’intelligence n’est pas obligatoirement une question de degrés, mais peut se déployer selon des actions et des modes divers » souligne l'éthologue [source]. C'est dans ce contexte que la notion de sentience conduit à la proposition de reconnaître aux animaux une personnalité juridique de personnes physiques non humaines [source].

Humain vs machine

2. Émotion

3. Transhumanisme

4. Paradoxe de Moravec

Subjectivité

La subjectivité est une caractéristique qui différencie les humains (et probablement l'ensemble du règne animal) des machines (du moins jusqu'à nos jours, nous y reviendrons plus loin).

Pour cerner la notion de subjectivité, analysons la différence entre information (données) et savoir (connaissance) :

Information (données) : les données ou l'information se réfèrent généralement à des faits, des observations ou des éléments concrets. Elles sont souvent considérées comme objectives car elles peuvent être mesurées, vérifiées et partagées de manière relativement impartiale. Cependant, la collecte, le traitement et la présentation des données peuvent être biaisés en fonction des choix de collecte, de la méthodologie et de l'interprétation. Les données brutes en elles-mêmes sont neutres, mais la manière dont on les utilise peut être subjective.

- Savoir (connaissance) : la connaissance implique généralement une compréhension plus profonde et une interprétation des informations, notamment par leur contextualisation. Elle est influencée notamment par l'expérience, la perspective, ou encore la culture.

D'autre part, la subjectivité peut jouer un rôle positif dans le développement de la connaissance :

créativité : la subjectivité peut stimuler la créativité, et partant susciter de nouvelles hypothèses, des théories originales et des solutions innovantes à des problèmes.

émotion et empathie : la subjectivité permet de comprendre et de ressentir les expériences des autres. Elle favorise l'empathie, qui est essentielle pour la compréhension des problèmes sociaux, culturels et humains.

moralité et éthique : la subjectivité joue un rôle central dans le développement de la moralité et de l'éthique. Les individus construisent leur compréhension de ce qui est bien et de ce qui est mal en fonction de leurs valeurs personnelles et de leurs croyances. Cela contribue à la réflexion éthique et à la prise de décisions morales.

Émotion

L'émotion est une autre caractéristique qui différencie les humains (et probablement l'ensemble du règne animal) des machines.

Si l'impulsivité et l'émotivité extrêmes risquent de nous faire prendre de mauvaises décisions, la seule rationalité peut nous y pousser tout autant. Ainsi les travaux d'Antonio Damasio auprès de personnes souffrant de lésions au niveau du lobe frontal du cortex cérébral, ayant pour effet de supprimer toute émotion, ont montré que ces personnes n'étaient plus aptes à prendre de bonnes décisions [source].

On peut définir l'intelligence émotionnelle comme la capacité à percevoir, comprendre, gérer et exprimer ses propres émotions, ainsi que celles d'autrui, afin de résoudre les problèmes et réguler les comportements liés aux émotions [source].

Quelques réflexions concernant l'émotion :

l'intelligence émotionnelle et relationnelle peut être utilisée aussi bien à des fins bienveillantes que malveillantes (cf. les pervers narcissiques).

ce que l'on appelle (abusivement ?) "l'intelligence artificielle" pourrait être capable de percevoir, et peut-être même d'interpréter les émotions des humains avec plus d'acuité que les humains eux-mêmes.

les deux points ci-dessus illustrent la nécessité d'un contrôle démocratique des moyens de production et de diffusion des savoirs (ce qui est loin d'être le cas, étant donné la sur-dominance de l'entreprise privée états-unienne Google dans le développement de l'IA).

Transhumanisme

Le transhumanisme est un ensemble de techniques et de réflexions visant à améliorer les capacités humaines, qu'elles soient physiques ou mentales, via un usage avancé de nanotechnologies et de biotechnologies. Cette notion très à la mode décrit en réalité une évolution qui a commencé avec l'invention des premiers outils, il y a plus de cinq mille ans. Les nanotechnologies et biotechnologies permettent aujourd'hui d'intégrer des outils dans le corps humain, jusqu'à modifier son code génétique (ce qui est déjà le cas d'une partie de l'alimentation industrielle, végétale ou animale).

On notera qu'une évolution inverse est déjà en train de prendre forme, c'est "l'humanisation" psychique de certains robots, qui ressemblent de plus en plus à des humains, aussi bien au niveau physique que psychique (notamment par des formes de subjectivité voire même d'émotion *).

(*) Rien n'empêche un ingénieur inventif de configurer un robot de telle façon que ses fonctionnalités soient modulées en réaction à "la vue" d'un paysage ou de "l'écoute" d'une musique, et de qualifier cette réaction de "émotionnelle".

De manière générale, il importe de ne persister dans une voie de R&D spécifique que si son ratio avantages/inconvénients a des chances substantielles de s'avérer favorable dans un délai raisonnable. L'évaluation de ce ratio doit prendre en compte les effets sur le psychisme des individus (cf. l'addiction numérique, et le stress informationnel), l'environnement, et la consommation énergétique [source].

Ainsi, alors que l'industrie pharmaceutique est parmi les plus polluantes, on notera la capacité des animaux à identifier des remèdes médicinaux de façon instinctive, et par conséquent très peu consommatrice d'énergie. D'autre part, nous verrons que l'efficacité énergétique de l'IA est très inférieure à celle des humains. Le tableau suivant illustre la thèse d'un classement inverse entre efficacités fonctionnelle et énergétique des animaux (A), humains (H) et robots (R).

| Efficacité fonctionnelle | Efficacité énergétique | |

|---|---|---|

| 1 | R | A |

| 2 | H | H |

| 3 | A | R |

Neutraliser le technologisme. En aval de la R&D, les humains ont encore la possibilité d'adapter leur mode de vie. Par exemple, j'ai banni la télévision et je n'ai pas remplacé mon gsm basique par un smartphone. Et, dans une démarche plus proactive, j'ai remplacé le système d'exploitation de mon ordinateur par Linux-Debian (en outre, j'ai conçu un système d'aide gratuite à la libération des ordinateurs familiaux : linux-debian.net).

Paradoxe de Moravec

Dans les années 1980, Hans Moravec soulignait que nos capacités de perception et de motricité nous semblent plutôt faciles et intuitives (comme la marche ou la reconnaissance d’objets) mais sont très difficiles à reproduire sous la forme d’intelligences artificielles tandis que des tâches cognitives de haut niveau (comme des calculs mathématiques complexes) sont très faciles pour elles [source]. Nous verrons que l'IA a aujourd'hui comblé ce déficit, mais au prix d'une gigantesque et croissante consommation d'énergie.

Éthique

Quels philosophes ont-ils associé l'intelligence au bien ?

Extraits de la réponse de chatGPT (janvier 2024) :

Platon (427-347 av. J.-C.) associait l'intelligence à la sagesse et à la recherche de la vérité. Dans ses dialogues, il mettait l'accent sur la connaissance et la compréhension comme éléments essentiels pour atteindre le bien

Aristote (384-322 av. J.-C.) développait la notion de phronesis, une forme de sagesse pratique, liant l'intelligence à la prise de décision éthique et à la recherche du bien commun.

John Stuart Mill (1806-1873), en tant qu'utilitariste, associait l'intelligence à la capacité de maximiser le bonheur et de minimiser la souffrance. Selon lui, une utilisation éclairée de l'intelligence devait conduire à des actions favorables au bien-être général.

Ces philosophes ont chacun apporté leur perspective unique sur la manière dont l'intelligence peut être liée à la poursuite du bien, que ce soit à travers la connaissance, la moralité, le bonheur ou le respect de la vie.

Déclin ?

Depuis le début du siècle, le QI baisse ... en Occident, de sorte qu'aujourd'hui le QI moyen est de seulement 98 en France et aux USA, contre 108 à Hong Kong et Singapour. Une des causes pourrait être la qualité et les budgets de l'enseignement, plus élevés dans les pays asiatiques [source]. Une étude plus récente suggère un éventail plus large de facteurs explicatifs : déclin des valeurs éducationnelles, dégradation des systèmes éducatifs et scolaires, télévision et médias, dégradation de l'éducation au sein des familles, dégradation de la nutrition, dégradation de la santé [source], mais confirme le rôle prépondérant de l'éducation. Ces études sont cependant contestées par d'autres chercheurs selon qui, si l’on prend en compte l’ensemble des données internationales, il n'y aurait pas de baisse mais plutôt stagnation, qui pourrait s'expliquer par l'approche de limites intrinsèques à l’espèce humaine [source].

Intelligence collective

2. Local vs global

3. Auto-organisation

4. Émergence

5. Liberalisme : marchés efficients ?

6. Théorie des jeux

7. Classe dirigeante

8. Contrôle des moyens de production

9. Dynamique collaborative

10. Projets

Introduction

Un exemple d'application de l'intelligence collective humaine est notre méthodologie visant à organiser la collaboration d'un millier de groupes constituants, pour concevoir et développer collectivement un système de DD, en mettant en place les conditions d'une dynamique d'auto-organisation et d'émergence (/groupes-constituants).

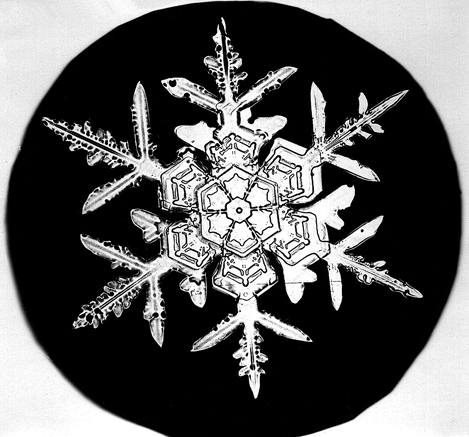

Photographie d'un flocon de neige [source].

L'auto-organisation est une caractéristique de l'intelligence collective. Elle n'est pas celle-ci, puisque le phénomène d'auto-organisation est observé également dans le monde non-vivant. Un exemple emblématique d'auto-organisation dans le monde du non-vivant est la structure (symétrique) d'un flocon de neige. Ses six branches constituant un hexagone sont caractéristiques de la structure cristalline de la glace. Au niveau microscopique chaque molécule d'eau est composé d'un atome d'oxygène entouré de deux atomes d'hydrogènes, formant un V autour du premier. Au niveau macroscopique, chaque branche est une fractale c-à-d que la structure de ses composants est invariable quel que soit le niveau d'échelle de l'observation.

Si l'on accepte l'hypothèse que l'intelligence existe en tant que caractéristique propre aux organismes vivants, alors il est de même pour l'intelligence collective.

Les images ci-dessous illustrent des formes simples d'intelligence collective, observées dans le monde animal. Elles ont en commun deux faits troublants : (i) elles s'expriment au travers de formations, composées des corps d'individus d'une même espèce, et (ii) ces formations présentent toutes une forme de symétrie, laquelle remplit une fonction précise.

Formations d'oiseaux en vol, pour minimiser leur consommation d'énergie. |

Formation de poissons, pour se protéger de prédateurs. |

Formation de fourmis, constituant un pont. |

Nous développons ici la thèse selon laquelle l'intelligence collective humaine consisterait en l'exploitation – consciente et proactive – des phénomène d'auto-organisation et d'émergence, par des intelligences individuelles communiquant via un réseau "le plus décentralisé possible".

On devine déjà ici l'importance du contrôle démocratique de l'infrastructure – matérielle et électronique – du réseau ...

Local vs gobal

Le passage conceptuel entre les dimensions individuelle et collective de l'intelligence correspond à la question fondamentale, dans le domaine scientifique, du lien entre niveaux local et global.

1. Physique quantique2. Conscience non localisée ?

3. Réseau décentralisé

Physique quantique

Dans l'état actuel des connaissances en physique, les lois naturelles qui régissent la physique des corps microscopiques (disons de taille inférieur à l'atome), semblent différentes de celles observées au niveau macroscopique. Le tableau suivant synthétise le principe d'incertitude (ou d'indétermination) d'Heisenberg, à savoir que la perception que nous avons du monde microscopique ne peut être exprimée (mesurée) qu'en termes probabilistes, c-à-d qu'il existe une incertitude – certes limitée (inférieure à 100 %), mais systémique (inhérente aux corps microscopiques) – quant à la connaissance que nous avons de la position ou de la quantité de mouvement d'une particule (NB : cela n'implique nullement que, dans la réalité, une particule pourrait être dans plusieurs positions ou états en même temps).

Données de la mesure d'un électron

| Micro | Macro | |

|---|---|---|

| Position | incertaines si état connu | certaines |

| État | incertains si position connue | certains |

"Incertaine" ≡ probabiliste.

- Question à chatGPT : l'affirmation suivante est-elle correcte ? : "La théorie quantique ne dit pas que la physique des corps microscopiques serait d'une nature différente de celle des corps macroscopiques, mais seulement que la mesure des phénomènes physiques à l'échelle microscopique ne peut être que de nature probabiliste".

- Réponse de chatGPT (extrait) : "La physique quantique ne se limite pas seulement à l'aspect probabiliste. Elle introduit également des concepts et des phénomènes tels que la dualité onde-particule ou encore l'intrication quantique (...) et d'autres aspects qui ne sont pas simplement une conséquence de la probabilité, mais qui remettent en question notre compréhension classique de la physique".

Quelques remarques :

Déterminisme. Soulignons que le principe d'incertitude est inhérent à la nature microscopique. Il n'est donc pas lié à une insuffisance des technologies actuelles de mesure. Autrement dit, contrairement au monde macroscopique, la physique microscopique est par nature soumise à une part de hasard, ce qui semble remettre en question le principe de déterminisme.

- Machines quantiques. Cependant, il existe des effets quantiques au niveau macroscopique, par exemple des résonateurs mécaniques dans une "superposition d’états" [source].

Discontinuité. Si la physique microscopique est qualifiée de mécanique quantique, c'est en raison d'une discontinuité inhérente à cette dimension, illustrée notamment par le fait qu'un électron ne peut se situer qu'à certaines orbites autour de son noyau.

Passons maintenant au corps vivants.

Conscience non localisée ?

Des scientifiques ont suggéré que la thèse selon laquelle le siège de la conscience est le cerveau des individus pourrait être incomplète. Ils suggèrent que les consciences individuelles seraient reliées par une conscience collective, de sorte que la conscience "individuelle" dépasserait spatialement voire aussi temporellement le corps (cf. notion de "conscience non-localisée" proposée par le cardiologue Pim van Lommel : source ; approfondir : scholar.google.com/scholar?q=nonlocal+consciousness).

Réseau décentralisé

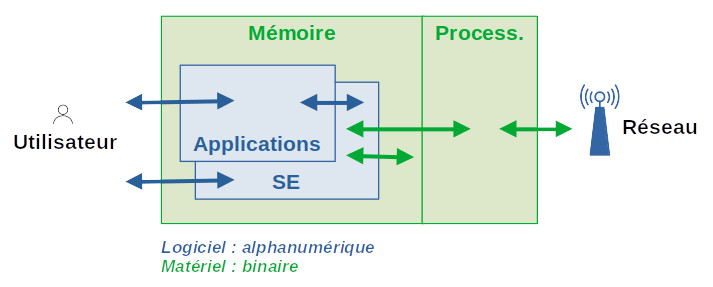

Quoi qu'il en soit, il est incontestable qu'une forme de conscience collective existe déjà, et se développe depuis que les humains construisent des moyens de communication (routes, écriture, Internet, ...). Internet est un réseau de communication virtuelle, c-à-d limitée aux seules données sous forme de bits. En outre, Internet intègre des unités de stockage (bases de données) et de traitement de ces données (requêtes, calcul, affichage sous diverse formes, ...).

Ainsi en combinant, au sein d'un protocole tel que Ethereum, des chaînes de blocs (bases de données distribuées sur un réseau pair-à-pair) avec des contrats intelligents, on peut constituer des applications décentralisées (dApp) telles qu'une organisation autonome décentralisée ("DAO") ;

De nombreuses applications pourraient fonctionner sur un réseau tel que Ethereum : gestion d'identité et de réputation, traçabilité des produits alimentaires, location d’appartements ou de voitures, bornes de ravitaillement électrique, achat de crédit d’énergie, instruments financiers auto-exécutifs, enchères, marchés de prédiction, etc. Les DAO sont notamment supposées réduire les coûts de vérification, d’exécution, d’arbitrage et de fraude [source].

Approfondir :

La dynamique d'intégration des sphères locales à la sphère globale, exprime sa potentialité dans le phénomène d'émergence, que l'on résume souvent par l'idée selon laquelle "le tout vaut plus que la somme des parties". Mais avant d'aborder la notion d'émergence, traitons une autre notion caractérisant l'intelligence collective : l'auto-organisation.

Auto-organisation

2. Structures dissipatives

3. Imprévisibilité

Définition

Je définirais l'auto-organisation, dans le monde du vivant, donc dans la sphère sociologique, comme étant le phénomène par lequel un groupe d'individus mènent des actions qui, vues de l'extérieur peuvent paraître coordonnées, alors qu'en réalité ces actions individuelles sont le fait d'individus qui ne se connaissent pas nécessairement, et peuvent même ignorer l'existance des autres membres du groupe informel qu'ils constituent (et qu'ils constituent sans le savoir nécessairement !). L'apparence de coordination est simplement la conséquence d'intérêts partagés entre les membres de ce groupe informel.

On notera que la méconnaissance du phénomène d'auto-organisation peut expliquer la propension de nombreuses personnes à interpréter des faits politiques ou économiques en termes complotistes. Autrement dit, ces personnes voient des complots même là où il n'y en a pas nécessairement !

Structures dissipatives

L'explication des intérêts partagés fonctionne pour le monde du vivant, et en l'occurrence pour des organismes qui ont une volonté. Elle n'est donc pas applicable pour expliquer l'auto-organisation dans le monde du non-vivant (cf. flocon de neige). Pour cela il faut se référer à la notion de "structures dissipatives" mises en évidence par Ilya Prigogine, qui fut professeur à l'université libre de Bruxelles et prix Nobel de chimie en 1977. On parle de structure dissipative dans le cas d'un système ouvert ne pouvant subsister dans un état stationnaire que s'il est traversé par des flux d'énergie. Une structure dissipative est donc un système hors équilibre : son énergie interne peut certes rester constante en moyenne (comme dans un système fermé) mais elle est constamment renouvelée (contrairement à un système fermé).

Approfondir : allocation-universelle.net/thermodynamique#structure-dissipative

Per Bak a montré que l'auto-organisation relève d'un processus qu’il a baptisé "criticalité auto-organisée" par lequel les structures dissipatives s'organisent à la manière des transitions de phase continues, comme le passage de l’état liquide à l’état solide, c-à-d au passage d’un état désordonné (l’état liquide) a un état ordonné (l’état cristallin). Des avalanches de bifurcations produisent des arborescences fractales : amplification des fluctuations ⇒ rupture de symétrie (avec invariance par changement d'échelle) ⇒ apparition et mémorisation d'information.

Les transitions abruptes nécessitent un apport extérieur d’information sous la forme d’un germe. Lors des transitions continues – cas des structures dissipatives – de l’information apparaît progressivement au fur et à mesure que la phase ordonnée se développe. Ces informations se propagent par percolation au sein de domaines d'Ising. Le modèle s'auto-organise de façon à maximiser l'énergie reçue (cf. supra les cacahuètes récompensant les essais réussis par le singe dans le modèle d'apprentissage de Bak et Stassinopoulos : #apprentissage).

Physique ⇒ biologie ⇒ sociologie. Selon François Roddier « le concept de réseau neuronal peut s’appliquer à tout système dissipatif considéré comme un ensemble d’agents échangeant de l’énergie et de l’information. On sait aujourd’hui que ces agents s’auto-organisent pour maximiser la vitesse à laquelle ils dissipent l’énergie (principe d'entropie maximale). C’est apparemment le cas des molécules d’air dans un cyclone, des bactéries dans une colonie, des fourmis dans une fourmilière comme des neurones dans notre cerveau. C’est aussi le cas des sociétés humaines. » [source].

Peut-on appliquer à tous ces phénomènes le même modèle d’auto-organisation ? Le modèle de Bak et Stassinopoulos représente un réseau régulier de neurones, mais les simulations faites avec des réseaux quelconques de noeuds reliés par des connexions arbitraires fonctionnent également. Le modèle de Bak et Stassinopoulos permet donc de modéliser la dynamique cognitive d'une population, dont chacun des individus peut échanger de l'information avec n'importe quel autre et déclencher une action. On peut alors parler d'intelligence collective ou de "cerveau global" [source].

Selon Roddier, en biologie l'ontogenèse correspondrait à une transitions abruptes, et la phylogenèse à une transition continue. L’information est mémorisée dans les gènes. Les êtres vivants qui partagent les mêmes gènes forment des domaines d’Ising appelés espèces animales ou végétales. Chez l’homme, l’information est principalement mémorisée dans son cerveau. Les sociétés humaines mémorisent à leur tour de l’information dans les livres, plus récemment dans les ordinateurs. C’est ce qu’on appelle la "culture". Les individus qui partagent la même culture forment des domaines d’Ising sous la forme de sociétés humaines. Les lois de la thermodynamiques expliquent donc aussi le phénomène sociologique d'auto-organisation [source1, source2].

Exploitation. La notion marxiste d'exploitation des salariés est fondée notamment sur l'appropriation de la plus-value collective, cette plus-value pouvant être vue comme le fruit du phénomène d'émergence.

Le modèle peut également expliquer la dynamique du progrès scientifique : « les sociétés humaines s’auto-organisent en formant un cerveau global capable de mémoriser toujours plus d’information. Cette information leur permet de dissiper de plus en plus d’énergie. C’est ce que nous appelons le progrès scientifique et technique. (...) Un réseau neuronal reçoit de l’information de sa source froide: c’est le cas du cerveau global que forme notre société. (...) La température de cette source froide peut s’exprimer en euros dépensés par bits d’information mémorisée. Cela soulève le problème du coût de la recherche scientifique. Plus ce coût est important, plus la température de notre source d’information est élevée et plus le rendement de Carnot de notre société est bas. (...) Les sociétés humaines s’effondrent lorsque leur rendement de Carnot est trop bas » [source].

Imprévisibilité

Une propriété importante des systèmes auto-organisé est qu'ils sont largement imprévisibles. L'auto-organisation n'est donc pas bénéfique ou vertueuse en soi. Ainsi un phénomène catastrophique peut fort bien être auto-organisé.

Moulin de fourmis (40sec)

Selon François Roddier « un système qui s'auto-organise a une évolution plus ou moins imprévisible. En effet si l'on pouvait parfaitement prévoir son évolution, celle-ci ne nous apporterait aucune information. Notre connaissance du système resterait inchangée. Le fait que son entropie diminue montre que ce n'est pas le cas : notre connaissance du système augmente. Il y a apparition d'informations nouvelles imprévues. Cela explique les difficultés des prévisions météorologiques. Cela explique aussi pourquoi le comportement des êtres vivants est largement imprévisible. L'évolution d'une société humaine l'est aussi. Au contraire, l'évolution d'un système isolé est largement prévisible : un mélange d'eau chaude et d'eau froide donne toujours de l'eau tiède [source p. 35] ».

Une question vient alors à l'esprit : le phénomène d'auto-organisation est-il suffisant en soit pour organiser efficacement la société (thèse de l'idéologie anarchiste/libérale) ? La réponse semble négative : dès lors que les phénomènes auto-organisés sont imprévisibles, comment pourraient-ils correspondent systématiquement aux besoins des humains, en tout lieu et à tout instant ? Le phénomène du moulin de fourmis évoqué plus haut illustre d'ailleurs le fait que l'auto-organisation n'est pas nécessairement rationnelle et bénéfique.

Ces faits conduisent à la question : comment organiser efficacement et durablement la société humaine ?

Émergence

L'émergence est le phénomène par lequel "le tout vaut plus que la somme de ses parties". Elle est déterminée par deux propriétés d'une population : sa taille et sa diversité.

Définir l'émergence comme le phénomène par lequel le tout vaut plus que la somme des parties peut paraître abusif dans la mesure où il ne respecte pas le premier principe de la thermodynamique ("rien ne se créé, rien ne se perd"). Cependant, le principe d'émergence ne s'applique pas à la matière ou à l'énergie, mais à des effets ou fonctionnalités, que l'on observe qu'au seul niveau global.

La vie elle-même est un processus émergent : à partir de réactions chimique, un processus d'auto-organisation conduit progressivement à l'élaboration de structures complexes.

Ainsi par exemple, des exemples d’intelligence émergente se trouvent chez les groupes d’animaux sociaux, comme les fourmis ou les abeilles, où l'on observe, à l’échelle du groupe, une forme d’intelligence qu’on ne trouve pas à l’échelle de chaque animal séparé [source].

Notons que les effets émergents ne sont pas nécessairement rationnels ou bénéfiques, comme l'illustrent les lynchages collectifs par des groupes d'humains.

Un possible contre-exemple de l'émergence est donné, selon la thèse dite du "covidisme", par le cas des experts en épidémiologie (notamment ceux de l'OMS) qui, enfermés dans leur tour d'ivoire des modèles mathématiques – nécessairement simplistes au regard de l'extrême complexité des phénomènes biologiques – ont fait imposer aux populations une stratégie "anti-épidémique", fondée sur la peur et la coercition, et dont les effets pervers sont d'une telle ampleur que ce seraient eux, et non le virus qui expliqueraient la majorité de la surmortalité toutes causes observée entre 2020 et 2022.

Cependant, au moins chez les humains, le travail de groupe peut participer à rehausser le niveau moyen de capacité de chacun des individus : ainsi par exemple, on chante plus juste à plusieurs que tout seul, car on se corrige en écoutant les autres [source]. Et cela sans aucune forme d'organisation.

La formation, l'information et l'organisation des individus peut améliorer leurs performances individuelles et collectives. Ainsi la délibération est une technique pouvant produire des effets d'émergence. Elle peut opérer comme suit [source] :

- répertorier les informations ;

- classer les arguments en "bons" et "mauvais" ;

- obtenir un consensus (et si celui-ci s'avère impossible il faut alors voter).

Landemore rappelle diverses théories éclairant le phénomène d'émergence [source], notamment en illustrant l'importance du nombre et de la diversité des membres du groupe :

- théorème du jury de Condorcet :

- thèse : plus les membres d'un groupe de votants soumis à la règle de la majorité simple seront nombreux, plus la probabilité de la vérité de la décision sera grande : la limite de cette probabilité sera la certitude (voir aussi théorème central limite) ;

- hypothèse principale : votes indépendants (pas de suivisme) ;

- miracle de l'agrégation :

- thèse : des expérimentations montrent que les réponses moyennes, d’un grand échantillons d'individus, à des questions ayant une solution vérifiable, tendent à être remarquablement correctes, car les erreurs des individus étant distribuées de manière symétrique autour de la bonne réponse, elles se compensent au niveau général ;

- hypothèse principale : distribution aléatoire des erreurs ;

- diversité cognitive :

- thèse : (i) L’erreur collective d’un groupe équivaut à l’erreur individuelle moyenne moins la diversité prédictive collective ; autrement dit, lorsqu’il s’agit de faire des prédictions, la différence cognitive entre les votants est tout aussi importante que la compétence individuelle ; (ii) le groupe fait nécessairement de meilleures prédictions que son membre moyen ; en outre, le gain en précision prédictive du groupe par rapport à son membre moyen augmente avec la diversité cognitive du groupe ;

- hypothèse principale : existence de corrélations négatives entre les modèles prédictifs des individus (sinon l'agrégation les accroît).

Diversité

cognitive

La diversité cognitive entre individus, par rapport à l'objet (physique, social, ...) étudié, est notamment fonction des capacités cognitives, méthodes, intuitions, milieu social, vécu ou encore âge respectifs. Elle se traduit par des différences dans les analyses des causes comme des effets (ainsi par exemple, une situation peut être perçue comme problématique pour certains mais pas par d'autres).

Lu Hong et Scott Page auraient établi (2004) qu’en raison des bénéfices de la diversité cognitive (c’est-à-dire la diversité des intelligences et des perspectives), des groupes non experts mais diversifiés sont souvent meilleurs, dans la résolution de problèmes complexes, que des groupes d’experts [source]. Ainsi selon Hélène Landemore : « il vaut souvent mieux avoir un groupe de personnes cognitivement diverses qu’un groupe de personnes très intelligentes qui pensent de la même manière. En effet, alors que des personnes très intelligentes qui pensent de la même manière vont avoir tendance à s’arrêter rapidement sur la solution qui leur paraît la meilleure sans chercher plus loin, les membres d’un groupe cognitivement plus divers ont la possibilité de se guider les uns les autres dans l’exploration d’autres possibilités : ils ne s’arrêtent pas à la solution commune retenue par ceux qui pensent pareillement et se donnent ainsi une chance de trouver la meilleure solution entre toutes (l’optimum global) » [source].

À cet égard il importe de distinguer :

- réductionnisme : qui réduit le complexe au simple (procédé courant dans l'enseignement et la modélisation);

- spécialisation (cas des experts) : qui développe une connaissance toujours plus complexe d'un domaine toujours plus réduit.

Dans les deux cas il y a risque de décrochage par rapport au réel, et de dérive vers le dogmatisme voire le scientisme. Dans une société qui survalorise l'expertise (c-à-d la division du travail), le suivisme peut alors conduire au phénomène du "moulin de fourmis" voire à des prophéties auto-réalisatrices (cf. le "covidisme" ?).

Ceci dit, l''émergence ne remet évidemment pas pour autant en question l'utilité des experts, notamment lors de la phase 1 de la délibération (cf. supra).

Auto-organisation

et émergence

L'émergence concerne aussi les machines, comme l'illustrent des expériences sur les automates cellulaires et la robotique en essaim. Une équipe de chercheur de l'ULB a ainsi montré que des robot peuvent, collectivement, séquencer des actions dont l’ordre d’exécution est à priori inconnu. Dans la méthode appliquée, les deux paradigmes robotiques – délibératif (sens-modèle-planifier-acte) et réactif (sens-acte) – traditionnellement considérés comme incompatibles, coexistent d’une manière particulière : la capacité de planifier émerge au niveau collectif, à partir de l'interaction d’individus réactifs. [source]. Cette expérience est particulièrement intéressante car elle décrit une dynamique "d'émergence de l'émergence", fondée sur une forme d'auto-organisation.

Dans la vidéo ci-dessous, l'épidémiologiste Didier Raoult évoque un phénomène étonnant : la somme des décisions individuelles, apparemment non concertées, de se faire tester reflète de façon très précise l'évolution statistique d'une épidémie (courbe en cloche).

Prendre en compte l'intelligence collective (juin 2020- 0m52s)

Démocratie

Il résulte de l'effet d'émergence que la démocratie pourrait s'avérer supérieure à l'oligarchie d'un point de vue épistémique. Mais qu'en est-il du passage de la démocratie représentative à directe ? Pour Landemore « il y a une limite théorique à l’augmentation de l’intelligence collective par l’introduction de toujours plus de points de vue. Dans l’agrégation de jugements, la diversité cognitive n’est pas une fonction linéaire du nombre de jugements agrégés et il y a un retour sur apport qui, au-delà d’un certain seuil, va s’amenuisant. (...) Ce problème de seuil suggère a priori la supériorité épistémique de la démocratie représentative sur la démocratie directe dans les sociétés de masse » [source].

Cette thèse de non linéarité (il y aurait un plafond) reste à prouver. Mais même en supposant sa validité théorique, il est hautement probable qu'en pratique le progrès technologique augmente constamment cette limite de sorte qu'il y a au moins linéarité. Ce progrès technique et technologique est illustré par notre méthodologie de conception et développement d'un système de gouvernance de démocratie directe (cf. /groupes-constituants), qui vise à activer les phénomènes d'auto-organisation et d'émergence, au moyen de trois principes fondamentaux : les comparaisons croisées, les validations itératives et la redondance initiale. Elle organise le travail collaboratif de plusieurs milliers de personnes, et il n'est pas évident d'identifier une limite théorique ou pratique au nombre maximum de participants ...

Médias vs réseaux sociaux : qui dit la vérité (2016, 1m5s)

Lorsqu'il s'agit de classer les causes de mortalité par ordre d'importance, les réseaux sociaux sont plus proches de la vérité scientifique que les médias "d'information". Est-ce une illustration de l'intelligence collective, ou de la propension des médias au sensationnalisme ? L'intelligence collective serait-elle plus performante sans l'influence de la presse ?

Liberalisme : marchés efficients ?

La notion économique de marché est un cas de théorie de l'auto-organisation. Selon cette théorie, chaque individu n'aurait qu'à viser la maximisation de son profit personnel pour que, via le mécanisme des marchés et des prix, s'opère une allocation – supposée optimale – de l'ensemble des biens et services. Par "optimale", on entend que cette allocation est la meilleure possible pour chacun et la collectivité. Les marchés sont ainsi supposés "efficients". Autrement dit, toute organisation des marchés par l'État serait nuisible par nature. Cependant de nombreux faits suggèrent que le postulat d'efficience naturelle des marché n'est pas pertinent (cf. allocation-universelle.net/principes-monetaires#marches-inefficients).

Dans une approche biologique, François Roddier extrapole le modèle de Bak et Stassinopoulos (cf. supra #apprentissage) à l'économie, en assimilant l'excitation des neurones à la richesse monétaire des individus. Les signaux d'entrée expriment le besoin en produits ou services. La transmission des signaux correspond à des transactions financières. En l'absence de percolation, ces transactions se limitent à des placements financiers. Lorsque le réseau percole, il conduit à une offre commerciale. Dans ce schéma, l'économie financière représente les réflexions du cerveau global. L'économie de production traduit ses actions réelles [source].

On est ici au niveau macroéconomique, mais l'économie – science de la gestion des ressources – doit également être étudiée au niveau microéconomique. À ce niveau, la théorie des jeux propose une description formelle d'interactions stratégiques entre agents (appelés « joueurs »).

Théorie des jeux

2. Jeux répétitifs

Équilibre non-collaboratif

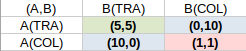

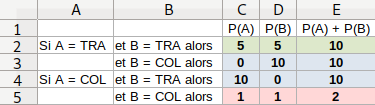

Le dilemme du prisonnier est un fondement de la théorie des jeux. Le tableau suivant montre les règles de ce jeu, l'objectif des joueurs/prisonniers étant de minimiser leur peine, alors qu'ils ne connaissent pas la stratégie adoptée par l'autre, et n'ont pas de moyen d'influencer celui-ci.

PS : on pourrait reformuler le jeu de sorte que l'objectif est de maximiser un gain, cela revient au même.

Les règles sont les suivantes :

- si les deux accusés se chargent l'un l'autre (trahison), le juge les condamne à 5 ans chacun ;

- si les deux accusés collaborent pour se couvrir, le juge confronté au doute les condamne chacun à la peine minimale de 1 ans ;

- si l'un couvre l'autre (COL) mais que celui-ci l'accuse (TRA), le premier est condamné à la peine maximale (10 ans) tandis que le second est libéré.

On peut résumer ces règles sous forme de matrice.

Le tableau suivant est une présentation plus intuitive.

Lecture ligne 3 : si A trahit et B collabore alors A est libéré tandis que B est condamné à 10 ans de prison (NB : les joueurs ne connaissent pas le choix de l'autre).

La colonne E montre que ce jeu (i) n'est pas à somme nulle (la colonne contient des valeurs non nulles) ; et (ii) est à somme variable (les valeurs de la colonne ne sont pas identiques).

Paradoxe. Ce jeu est conçu de telle sorte que son résultat est paradoxal :

- chaque peine individuelle minimale correspond à la trahison : ce sont les cases C3 et D4 ;

- la peine collective minimale correspond à la collaboration : 2 est le minimum de la colonne E, et il correspond à la collaboration pour A comme pour B.

D'autre part, l'incertitude concernant le choix opéré par l'autre joueur (par exemple A) a pour effet (étant donné les valeurs du tableau) que :

- si A trahit, alors B minimise sa peine en trahissant (5 < 10) ;

- si A collabore , alors B minimise sa peine en trahissant (0 < 1).

On constate donc que les dans les deux cas (c-à-d quel que soit le choix fait par A) B a intérêt à trahir. Et comme les situations de A et B sont symétriques la même conclusion vaut également pour A. Chacun des deux joueurs devrait donc trahir l'autre (ligne 2). Or dans ce cas la peine obtenue ne correspond ni aux peines minimales individuelles ni à la peine minimale collective, et cela alors que le comportement des joueurs est pourtant supposé rationnel.

La cause de ce paradoxe est double : (i) les règles du présent jeu (qui en l'occurrence sont fondées sur la logique du système judiciaire) sont conçues pour inciter à la trahison ; (ii) l'incertitude quant au choix opéré par l'autre joueur conduit à minimiser le risque d'obtenir la peine maximale (c-à-d à maximiser la probabilité d'obtenir un temps libre maximum).

Stratégie dominante. Dans un jeu dont la stratégie optimale est indépendante de l'anticipation faite par le joueur quant à l'action simultanée/inconnue des autres joueurs (ici, A a intérêt à trahir quelque soit le choix fait par B), la stratégie optimale est dite "dominante".

Interprétations. Le résultat du dilemme du prisonnier requiert deux commentaires importants :

L'on pourrait très bien concevoir des jeux dans lesquels les joueurs n'ont pas d'autre choix rationnel que de collaborer (programmation du résultat théorique). On ne peut donc extrapoler le résultat du dilemme du prisonnier à tous les jeux possibles et imaginables, et conclure que le dilemme du prisonnier démontrerait que dans la vie en général les individus n'ont pas intérêt à collaborer ou ne sont pas enclins naturellement à le faire. Comprenons donc bien que le dilemme du prisonnier ne révèle absolument rien sur la nature humaine en général (*), mais par contre il nous en dit sans doute un peu sur ses concepteurs, qui ont préféré illustrer le principe de stratégie dominante par une stratégie non-collaborative plutôt que de collaborative ...

(*) Néanmoins, les expérimentations de ce jeu permettent d'évaluer la propension d'une population de joueurs à collaborer ou trahir. En l'occurrence une expérience aurait donné 20% de collaborations et 80% de trahisons. Dans une autre expérience la répartition serait plus proche de la parité (question : la plus grande proportion de collaborations s'explique-t-elle par une plus large connaissance du dilemme du prisonnier parmi les joueurs ?).

Il faut se garder d'associer systématiquement un caractère positif à la collaboration et négatif à la non collaboration (trahison) : tout est relatif au point de vue (c-à-d au référentiel). Ainsi un cartel peut maximiser ses revenus (au détriment du reste du monde ...) en convenant (i) de quotas de production et (ii) de punitions en cas de dépassement des quotas. Pour neutraliser cette collaboration l'État (ou une autorité internationale) peut par exemple assurer une quasi-immunité au membre du cartel qui révélera l'accord à la justice (trahison) et permettra ainsi de punir les autres membres du cartel [source p. 155].

Utilité/applications de la théorie des jeux :

permettre à une organisation d'influencer (programmer ?) le comportement de ses membres (NB : dans l'intérêt de la collectivité ... ou des seuls dirigeants de l'organisation) ;

Exemples :- quelles modifications apporter au mode de fonctionnement d'une organisation pour améliorer l'efficacité de la collaboration entre ses membres ?

- quels éléments du mode de fonctionnement d'une organisation non démocratique permettent-ils de neutraliser le risque de révolution démocratique ?

- indiquer aux individus quelle stratégie adopter pour minimiser les risques (maximiser les chances).

Jeux répétitifs

Si le jeu devient répétitif chaque joueur peut alors observer les choix précédents des autres joueurs, et implémenter des stratégies visant à influencer leur comportement. Selon une expérience réalisée en 1979 par Robert Axelrod, la stratégie socialement et individuellement optimale dans nos relations avec autrui est la suivante : coopérer à la première partie, puis adopter systématiquement le dernier choix fait par l'autre joueur (coopérer s'il a coopéré, trahir s'il a trahi) [source].

Selon une estimation, dans les jeux répétitifs, le pourcentage de trahisons serait proche de ... 100%, du moins lorsque les joueurs n'ont pas connaissance des conclusions d'Axelrod.

Cette stratégie dite "donnant-donnant" est de type "à mémoire courte" car elle consiste à ne tenir compte que de la dernière action de l'adversaire (coopération ou trahison) en faisant table rase du passé (même si le passé de l'adversaire n'est fait que de trahisons !).

Application. On notera que cette règle relève du bon sens et peut être appliquée aussi bien dans le travail professionnel avec les collègues que dans le travail éducatif avec les enfants (P.S. Appliquer ces conclusions exige donc de vaincre notre rancune tout autant que notre gentillesse. La raison doit l'emporter sur nos états d'âme ...). Au niveau des États, la stratégie "donnant-donnant" peut être appliquée dans la négociations des accords de libre-échange.

Encore mieux. En 2012 des chercheurs ont trouvé un type de stratégies supérieures au donnant-donnant : les stratégies "à déterminant nul". Celles-ci sont cependant éthiquement un peu plus problématiques, et cela pour deux raisons : (i) elles reposent sur un procédé statistique relativement complexe (et avantagent donc les individus capables de les comprendre/appliquer) ; (ii) elles consistent à contraindre la partie adverse. Pour ce deuxième point la problématique éthique est cependant tempérée dans la mesure où (a) il s'agirait d'une contrainte généreuse (résultat gagnant-gagnant) ; (b) dans les grandes populations qui évoluent, l'optimum ne serait plus cette contrainte généreuse, mais la coopération [source].

Une excellente vidéo de vulgarisation (14m36s) sur la théorie des jeux.

Classe dirigeante

On pourrait considérer qu'une classe dirigeante est une démocratie limitée à ses membres, ou encore que dans une démocratie directe la classe dirigeante serait constituée de l'ensemble de la population (de sorte que la notion de classe ne ferait plus sens). Dans ces phénomènes politiques et économiques la part d'auto-organisation ne doit pas être sous-estimée.